Activistas y funcionarios compiten para dar forma a las reglas y la comprensión pública de las nuevas herramientas de inteligencia artificial.

Las redes sociales tenían más de una década antes de que los esfuerzos para frenar sus efectos nocivos comenzaran en serio. Con la inteligencia artificial, los legisladores, activistas y ejecutivos no esperan tanto.

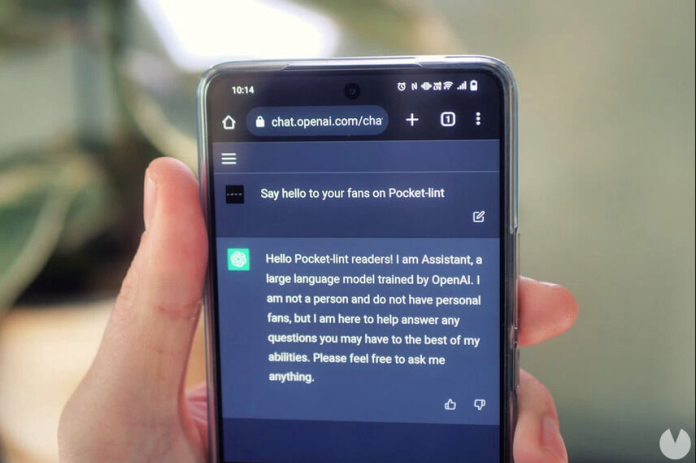

En los últimos meses, científicos galardonados, funcionarios de la Casa Blanca y directores ejecutivos de tecnología han pedido medidas de seguridad en torno a las herramientas de IA generativa como ChatGPT, el chatbot lanzado el año pasado por la startup OpenAI respaldada por Microsoft . Entre los que están en la mesa hay muchos veteranos de la continua batalla para hacer que las redes sociales sean más seguras.

Esos defensores ven el debate de la IA como una nueva oportunidad para influir en la forma en que las empresas fabrican y comercializan sus productos y para dar forma a las expectativas públicas de la tecnología. Su objetivo es moverse más rápido para dar forma al panorama de la IA y aprender de los errores en la lucha por las redes sociales.

“Perdimos la ventana en las redes sociales”, dijo Jim Steyer, director ejecutivo de Common Sense Media, una organización de seguridad infantil en Internet que durante años ha criticado las plataformas de redes sociales por cuestiones que incluyen la privacidad y el contenido dañino. “Era tarde, muy tarde, y las reglas básicas ya se habían establecido y la industria simplemente hizo lo que quería hacer”.

Tanto los activistas como los ejecutivos están impulsando una variedad de proyectos y propuestas para dar forma a la comprensión y la regulación para abordar problemas que incluyen el potencial de manipulación, desinformación y sesgo de la IA.

Common Sense está desarrollando un sistema independiente de calificaciones y revisiones de IA que evaluará productos de IA como ChatGPT en su manejo de datos privados, idoneidad para niños y otros factores. La organización sin fines de lucro planea lanzar el sistema este otoño y gastar entre $ 5 millones y $ 10 millones al año además de su presupuesto de $ 25 millones para financiar el proyecto.

Otros grupos de defensa de Internet, incluida la Fundación Mozilla, también están creando sus propias herramientas de IA de código abierto e invirtiendo en nuevas empresas que dicen que están construyendo sistemas de IA responsables. Algunas empresas inicialmente enfocadas en las redes sociales ahora están tratando de vender servicios a empresas de IA para ayudar a sus chatbots a evitar generar información errónea y otros contenidos dañinos.

Las empresas tecnológicas están compitiendo para influir en la regulación, discutiéndola con gobiernos globales que desconfían de la IA y están ansiosos por capitalizar sus oportunidades. A principios de mayo, el presidente Biden se reunió con los directores ejecutivos de empresas como OpenAI, Microsoft y Google en la Casa Blanca. El CEO de OpenAI, Sam Altman, ha pasado semanas reuniéndose con legisladores y otros líderes a nivel mundial para discutir los riesgos de la IA y la idea de su empresa de una regulación segura.

Altman y el presidente de Microsoft, Brad Smith, han abogado por una nueva agencia reguladora que otorgaría licencias a grandes sistemas de IA. CEO de Tesla , Elon Musk, quien el miércoles anunció el lanzamiento oficial de su nueva startup de IA , dijo en mayo que el gobierno debería convocar un comité de supervisión independiente, que podría incluir ejecutivos de la industria, para crear reglas que garanticen que la IA se desarrolle de manera segura.

La Comisión Federal de Comercio también está analizando detenidamente la IA. Está investigando si OpenAI ha “participado en prácticas desleales o engañosas” derivadas de información falsa publicada por ChatGPT, según una citación civil hecha pública la semana pasada. Altman dijo que OpenAI confía en que cumple con la ley y “por supuesto que trabajaremos con la FTC”.

Sobre toda esta actividad se vislumbra el sentimiento creciente entre muchos activistas y legisladores de que los años de esfuerzos para regular o cambiar las empresas de redes sociales, incluidas las metaplataformas matrices de Facebook, Twitter y TikTok, fueron insatisfactorios. Facebook se fundó en 2004 y Twitter en 2006, pero la discusión generalizada sobre la regulación realmente no despegó hasta después de los descubrimientos de la interferencia rusa y otros problemas en las elecciones estadounidenses de 2016.

“El Congreso no cumplió con el momento en las redes sociales”, el senador demócrata Richard Blumenthal dijo durante una audiencia en el Congreso sobre AI en mayo. “Ahora tenemos la obligación de hacerlo con IA antes de que las amenazas y los riesgos se vuelvan reales”.

Incluso después de que los ejecutivos de las redes sociales en los últimos años pidieron más regulación, no se han establecido nuevas leyes federales de EE. UU. que exijan a las empresas proteger la privacidad y los datos de los usuarios o que actualicen las reglas de casi tres décadas sobre cómo las plataformas controlan el contenido.

Algunos de los activistas que son veteranos de esas batallas dicen que dos lecciones importantes de esta era son que no se puede confiar en que las empresas se autorregulen y que el gobierno federal está demasiado paralizado para aprobar una legislación significativa. “Hay un vacío masivo”, dijo Steyer de Common Sense Media.

Sin embargo, él y otros dicen que se sienten alentados por la disposición de las empresas de inteligencia artificial para discutir temas importantes.

“Vemos que algunas de las personas de los equipos de confianza y seguridad de las redes sociales ahora están en empresas de IA”, dijo L. Gordon Crovitz, cofundador de NewsGuard, una empresa que rastrea y califica sitios de noticias. Crovitz, ex editor de The Wall Street Journal, dice que estas personas parecen mucho más empoderadas en sus funciones actuales. “El lenguaje corporal es ‘hemos sido liberados’”.

Los modelos de lenguaje extenso, como GPT-4, se entrenan en cualquier cosa que se pueda extraer de Internet, pero los datos contienen grandes fragmentos de incitación al odio, información errónea y otros contenidos dañinos. Entonces, estos modelos se refinan aún más después de su entrenamiento inicial para eliminar parte de ese contenido incorrecto en un proceso llamado ajuste fino.

NewsGuard ha estado hablando con empresas de IA sobre la concesión de licencias de sus datos, que Crovitz llama un “catálogo de todas las narrativas falsas importantes que existen”, para ajustar y reforzar las barreras de protección de los modelos de IA contra la producción de ese tipo de información errónea y falsa. narrativas.

Ravi Iyer, ex gerente de productos de Meta, ahora está en la Escuela de Negocios Marshall de la Universidad del Sur de California y está desarrollando una encuesta que rastrea cómo las personas experimentan los sistemas de IA. Espera que la encuesta influya en la forma en que las empresas de IA diseñan e implementan sus productos.

“Necesitamos saber que las plataformas pueden elegir y recompensarlas por no tomar las decisiones equivocadas”, dijo Iyer.

La Fundación Mozilla, una organización sin fines de lucro que construye el navegador de Internet Firefox, dijo que está construyendo modelos de código abierto como alternativas a los grandes modelos privados de IA. “Necesitamos construir alternativas y no solo abogar por ellas”, dijo Mark Surman, presidente de Mozilla.

Steyer describió el sistema de calificación de IA que se está construyendo en Common Sense como el más ambicioso en la historia de la organización sin fines de lucro. Tracy Pizzo Frey, una consultora que trabajó anteriormente para Google y está ayudando a diseñar el sistema, dijo que no existe una forma establecida de evaluar la seguridad de las herramientas de IA.

Hasta ahora, Common Sense está analizando siete factores, incluida la transparencia de las empresas sobre lo que pueden hacer sus sistemas y dónde todavía tienen deficiencias. La organización sin fines de lucro puede tener en cuenta la cantidad de información que brindan las empresas sobre sus datos de capacitación, que las empresas, incluida OpenAI, ven como secretos competitivos.

Frey dijo que Common Sense no solicitará datos patentados, pero necesita información que ayude a los padres y educadores a tomar decisiones informadas sobre el uso de la IA. “No hay reglas sobre cómo se ve la transparencia”, dijo Frey.